Últimamente, se ha hablado cada vez más de agentes de IA que toman una orden y llevan a cabo físicamente la tarea, incluidos los toques y deslizamientos necesarios, en su teléfono. Esta charla sobre la creación de un agente de IA me recuerda mucho al “nuevo Asistente de Google” que se anunció con el Pixel 4 en 2019.

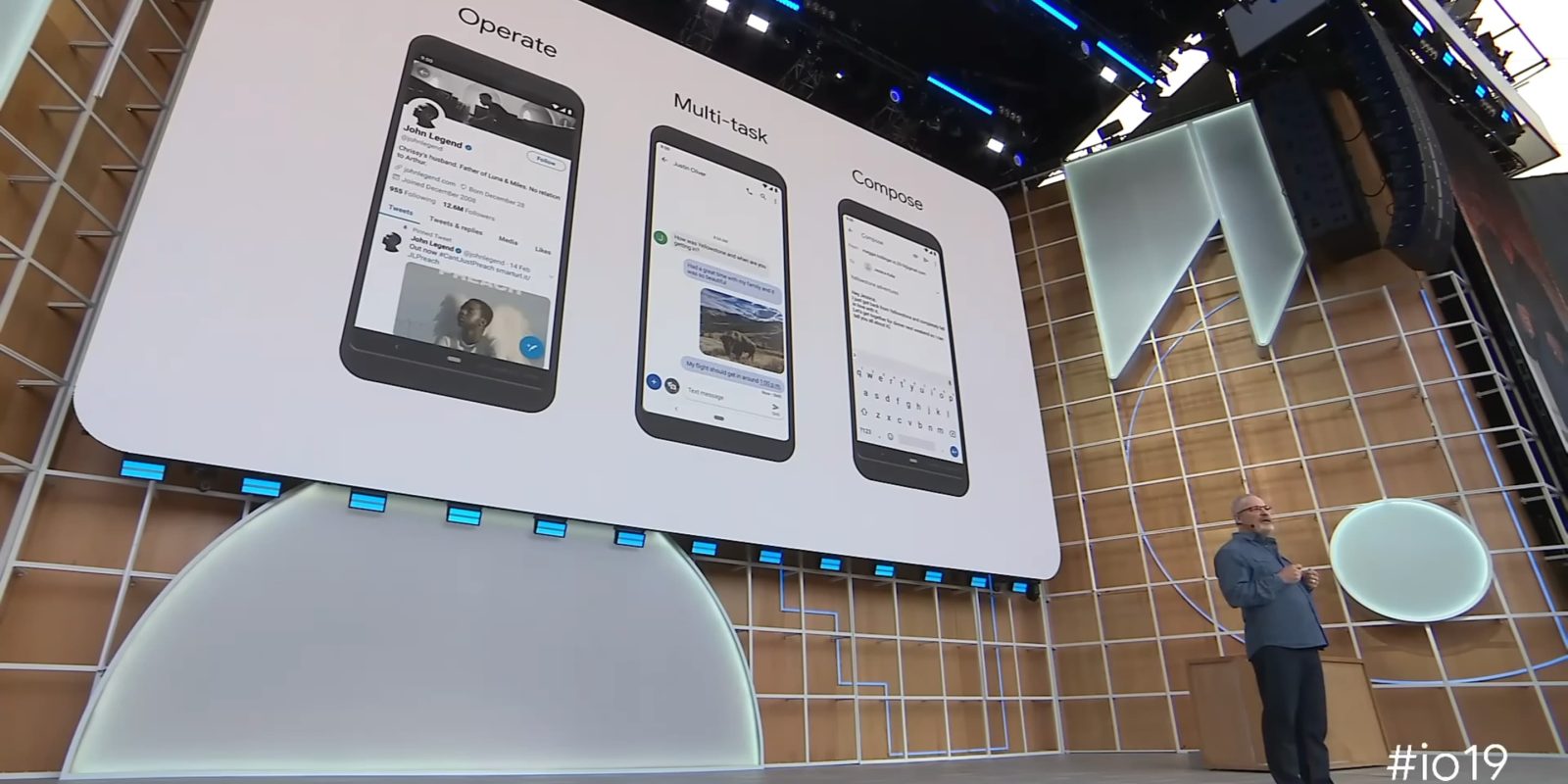

En I/O 2019, Google demostró por primera vez este Asistente de próxima generación. La premisa era que el procesamiento de voz en el dispositivo haría que “tocar el teléfono pareciera casi lento”.

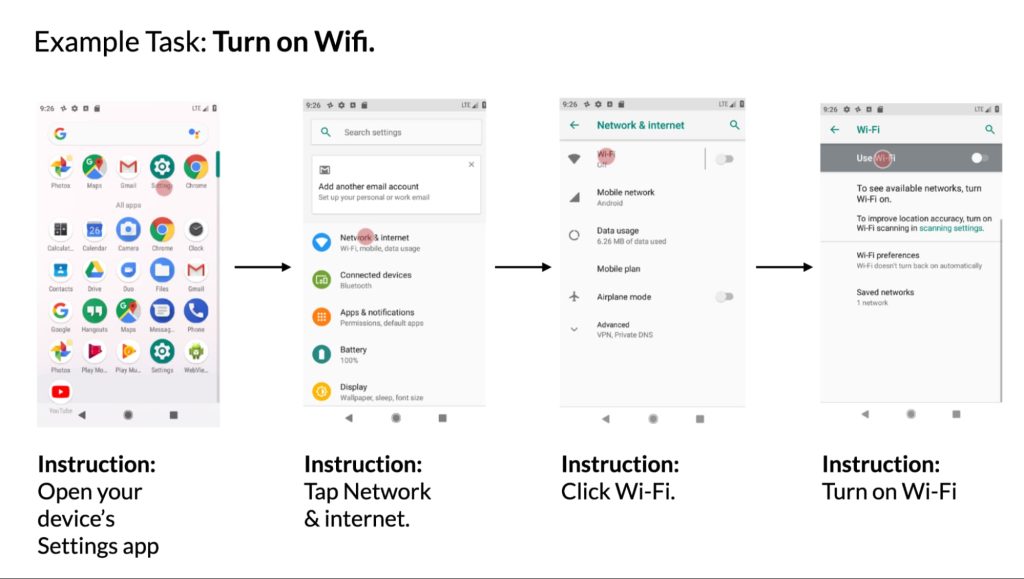

Google demostró comandos simples que implicaban abrir y controlar aplicaciones, mientras que la idea más compleja era “cómo el Asistente integrado del dispositivo podría orquestar tareas entre aplicaciones”. El ejemplo fue recibir un mensaje de texto, responder por voz y luego tener la idea de buscar y enviar una foto adjunta. La capacidad de “Operar” y “Multitarea” se ha complementado con una función de “Redacción” en lenguaje natural en Gmail.

Este Asistente de próxima generación le permitirá operar instantáneamente su teléfono con su voz, realizar múltiples tareas entre aplicaciones y completar acciones complejas, todo con una latencia casi nula.

El nuevo Asistente se lanzó en el Pixel 4 ese mismo año y estuvo disponible en todos los dispositivos de Google posteriores.

- “Toma una selfie.” Luego diga “Comparte esto con Ryan”.

- En una conversación de chat, diga “Responder, estoy en camino”.

- “Buscar clases de yoga en YouTube”. Luego diga “Comparte esto con mamá”.

- “Muéstrame los correos electrónicos de Michelle en Gmail”.

- Con la aplicación Google Photos abierta, diga “Muéstrame fotos de Nueva York”. Luego diga “Aquellos en Central Park”.

- Con un sitio de recetas abierto en Chrome, diga “Buscar brownies de chocolate y nueces”.

- Con una aplicación de viajes abierta, diga “Hoteles en París”.

Ésta es la idea fundamental detrás de los agentes de IA. Durante una llamada sobre resultados de Alphabet el mes pasado, se le preguntó a Sundar Pichai sobre el impacto de la IA generativa en Assistant. Dijo que permitiría al Asistente de Google “actuar más como un agente con el tiempo” e “ir más allá de las respuestas y rastrear a los usuarios”.

De acuerdo con La información Esta semana, OpenAI está trabajando en un agente ChatGPT:

“Este tipo de solicitudes provocarían que el agente realice clics, movimientos del cursor, escriba texto y otras acciones que los humanos realizan mientras trabajan con diferentes aplicaciones, según una persona con conocimiento del esfuerzo”.

Luego está Rabbit con su modelo de acción grande (LAM) entrenado para interactuar con interfaces móviles y de escritorio existentes para completar una tarea definida.

La versión 2019 del Asistente de Google parecía muy preprogramada, requiriendo que los usuarios siguieran ciertas frases en lugar de permitir que las personas hablaran con naturalidad y luego discernieran automáticamente la acción. En ese momento, Google dijo que el Asistente “funciona perfectamente con muchas aplicaciones” y que “continuaría mejorando las integraciones de aplicaciones con el tiempo”. Hasta donde sabemos, esto nunca ha sucedido, aunque algunas de las características que mostró Google ya no funcionan porque la aplicación ha cambiado. Un verdadero agente sería capaz de adaptarse en lugar de depender de las condiciones establecidas.

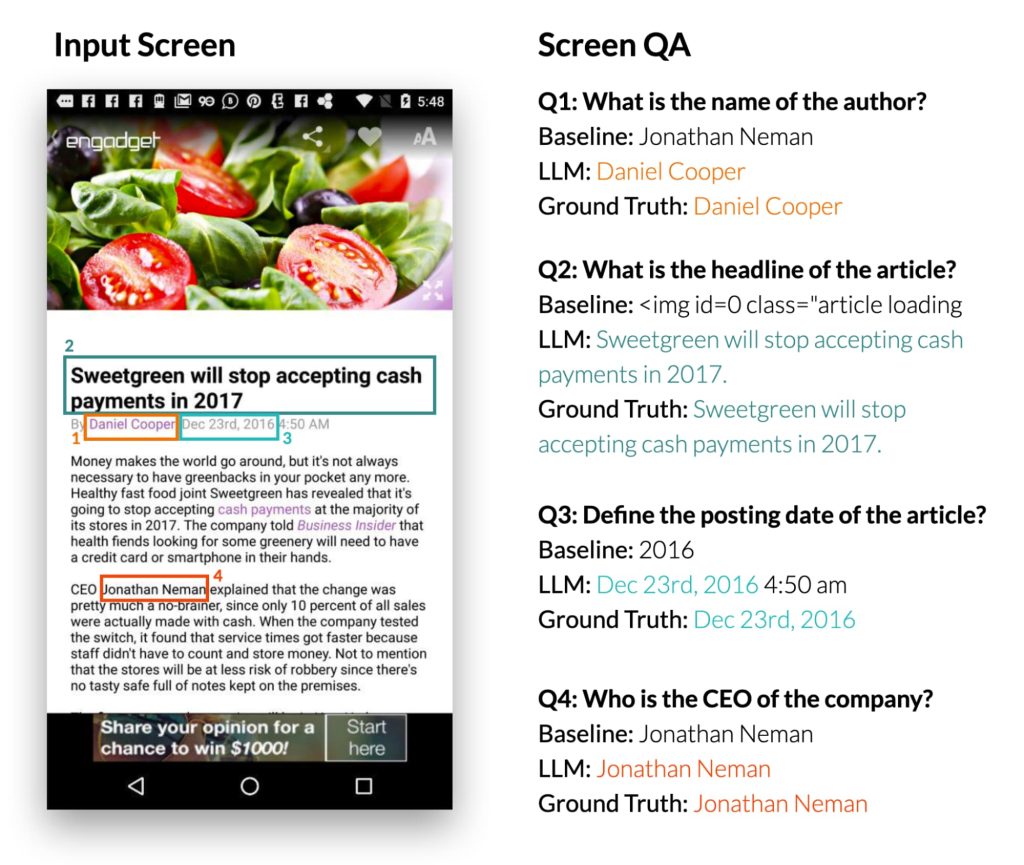

Es fácil ver cómo los LLM podrían mejorar esto: el año pasado, Google Research mostró trabajos en “Habilitar la interacción conversacional con la interfaz de usuario móvil utilizando modelos de lenguaje grandes.”

Google Research demostró que su enfoque es capaz de “comprender rápidamente el propósito de una interfaz de usuario móvil”:

Curiosamente, observamos que los LLM utilizaban sus conocimientos previos para inferir información que no se presenta en la interfaz de usuario al crear resúmenes. En el siguiente ejemplo, LLM dedujo que las estaciones de metro pertenecen al sistema de metro de Londres, mientras que la interfaz de usuario de entrada no contiene esta información.

También puede responder preguntas sobre el contenido que apareció en la interfaz de usuario y controlarlo después de recibir instrucciones en lenguaje natural.

Un agente Gemini AI para su dispositivo Android sería la evolución natural del primer intento de Google, que nunca se convirtió en un asistente integral que proporcionara una nueva forma de usar su teléfono. Sin embargo, funciones como transcribir la respuesta de un mensaje y poder decir “enviar” en vivo en la escritura por voz del Asistente de Gboard.

Parece que el esfuerzo anterior fue un caso en el que Google tuvo una idea demasiado pronto y no tenía la tecnología necesaria. Ahora que está aquí, sería prudente que Google priorizara este esfuerzo para poder comenzar a liderar el campo en lugar de intentar ponerse al día.

FTC: utilizamos enlaces de afiliados automotrices para generar ingresos. Más.

“Introvertido. Solucionador de problemas. Aficionado total a la cultura pop. Estudiante independiente. Creador”.