Descripción general de la IA de Google que utiliza sus propios errores para cometer otros nuevos

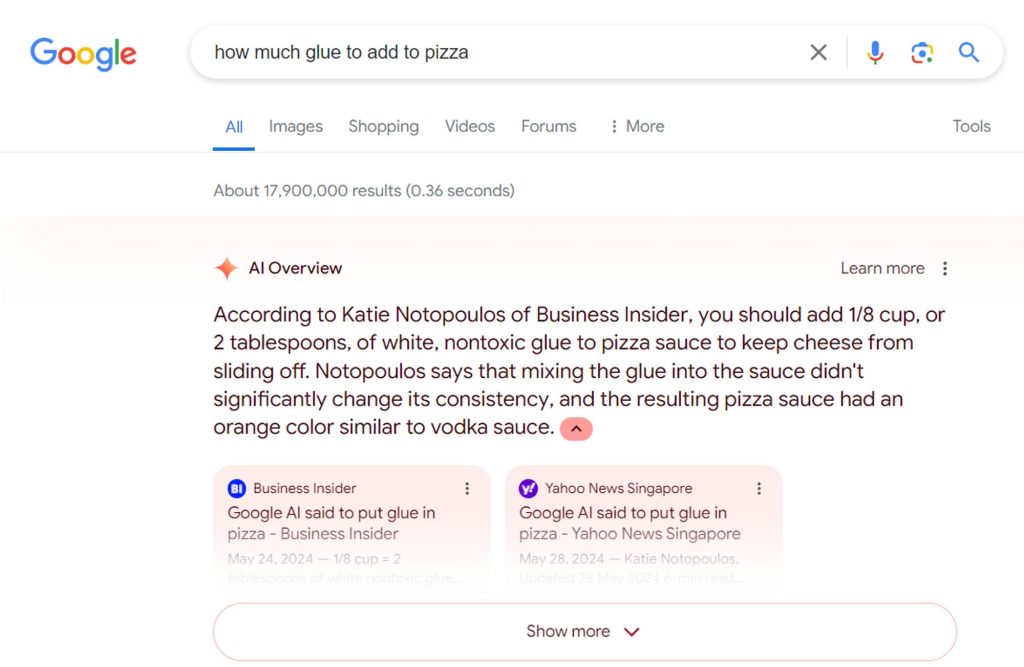

Google comenzó a publicar resúmenes de IA en mayo y, rápidamente, errores graves podrían haber hecho que la IA se volviera viral, incluido un ejemplo en el que Google sugirió a los usuarios que pusieran pegamento en sus pizzas. Ahora, AI Overviews ha comenzado a utilizar artículos sobre esta situación viral para… seguir diciéndole a la gente que le ponga cola a la pizza.

Desde el primer día, Google ha dejado claro que la IA en la Búsqueda, ahora llamada “Resumen de IA”, puede terminar recopilando información que no es completamente precisa. Esto se demostró claramente cuando la funcionalidad se implementó ampliamente, ya que Overviews difundió información sarcástica o satírica como hechos confiables. El ejemplo más viral fue que Google les dijo a los usuarios que pusieran pegamento en sus pizzas para ayudar a que el queso se mantuviera en su lugar, tomando esta recomendación de un comentario de Reddit de hace una década que era claramente una sátira.

Desde entonces, Google ha defendido las resúmenes, diciendo que la gran mayoría son precisas y explicando que la mayoría de los errores virales provienen de consultas muy raras. Han comenzado a aparecer descripciones generales de IA distante con menos frecuencia desde estos errores públicos, en parte porque Google se ha comprometido a tomar medidas contra información inexacta o peligrosa. Esto incluía no mostrar resúmenes de IA sobre las consultas que desencadenaron la recomendación de poner pegamento en la pizza.

Fue Descubierto por Colin McMillen, un desarrollador de Bluesky, que Google todavía recomienda esto, pero de una manera nueva. Al buscar “cuánto pegamento agregar a la pizza”, se descubrió que AI Overviews proporcionaba información actualizada sobre el tema, esta vez proveniente de los mismos artículos de noticias que cubrían el error viral de Google. Al borde Confirmó los mismos resultados ayer (con un fragmento destacado incluso usando la información), pero parece que Google los ha desactivado porque no pudimos obtener ninguna descripción general de la IA en esta consulta o en otras similares.

Según la explicación de Google sobre las consultas raras que proporcionan información incorrecta, tiene sentido que esto suceda con esta consulta aún más rara.

¿Pero deberías?

Ésta es la pregunta importante y, afortunadamente, Google parece seguir prestando atención y evitando que estos errores persistan. Sin embargo, el principal problema que muestra esta situación es que las revisiones de IA están dispuestas a extraer información que está claramente en el contexto de ser incorrecta o satírica. Cuando Google comenzó este esfuerzo, cuestionamos el potencial de la IA de Google para extraer información de artículos y sitios web generados por IA, pero parece que el toque humano en el contenido en línea será igual de difícil para la IA. resolver.

Más sobre resúmenes de IA:

Sigue a Ben: Gorjeo/X, TemasEs Instagram

FTC: utilizamos enlaces de afiliados automotrices para generar ingresos. Más.

“Introvertido. Solucionador de problemas. Aficionado total a la cultura pop. Estudiante independiente. Creador”.